閱覽人數: 216

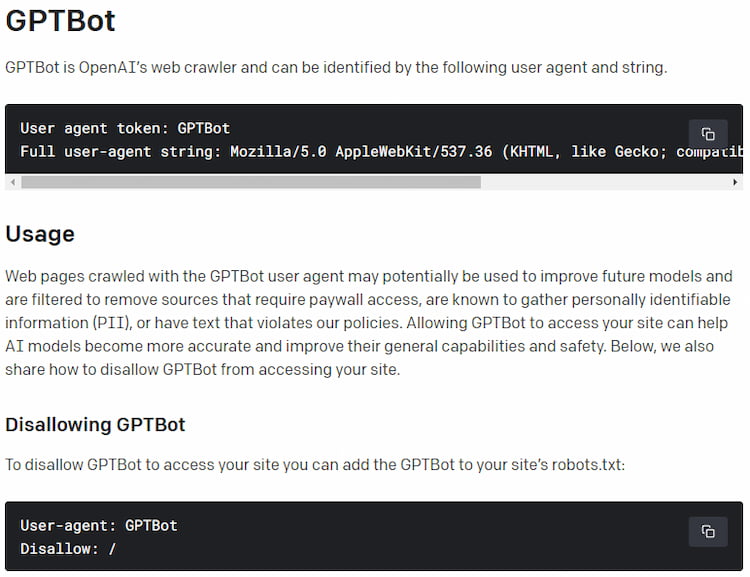

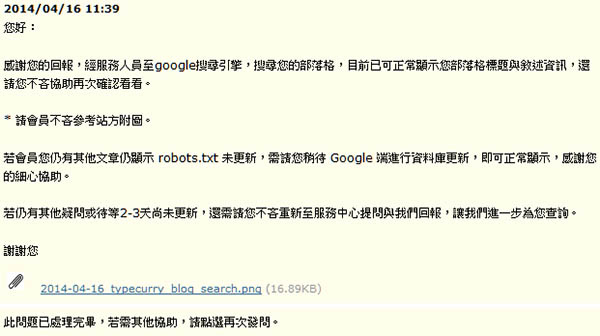

自從OpenAI所開發的生成式模型(Generative Pre-trained Transformer)爆紅之後,

關於於其訓練資料來源(網路、書籍與公開文本)正當性的質疑便從未停止過,

或許是為了回應大眾對於隱私與智慧財產權的憂慮,

OpenAI總算在日前釋出了其網頁爬蟲”GPTBot”的相關細節;

若打算拒絕提供任何資訊或控制可給OpenAI使用之內容範圍的話,

可別忘記趕緊修改自己網站的robots.txt囉! 繼續閱讀

標籤: AI, robots.txt, SEO, 網路

閱覽人數: 3,975

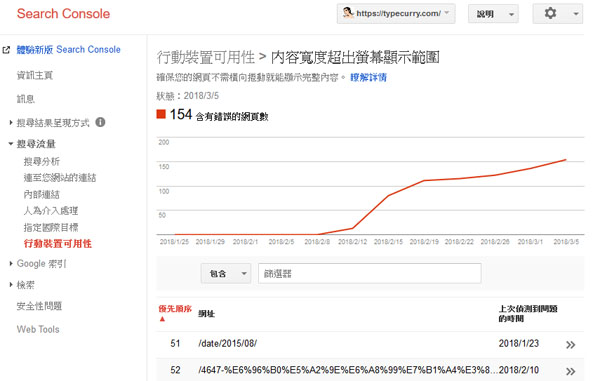

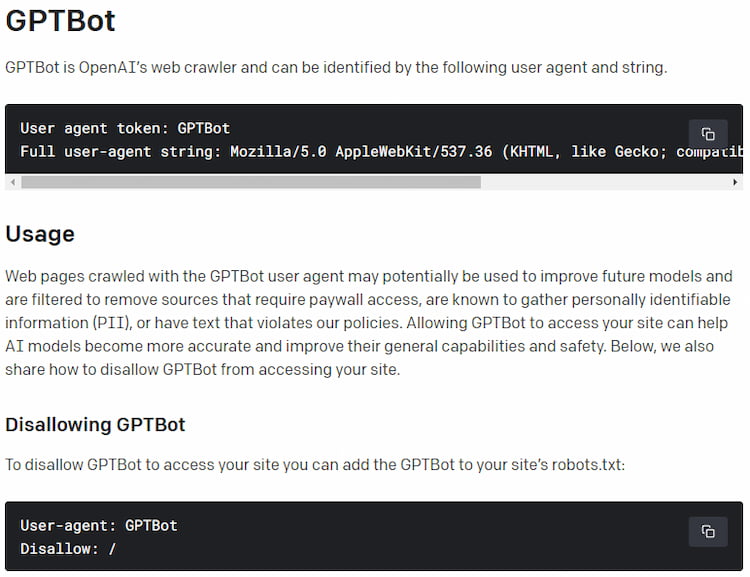

自從把Blog搬到WordPress後,Google網站管理員中的”行動裝置可用性”就一直顯示有錯誤,

然而用手機打開顯示錯誤的網址一切正常、和用電腦瀏覽並沒有什麼特別差異,

管理頁面亦顯示網站索引和Googlebot都能抓取網站內容,

想說會否伺服器太慢的關係,PageSpeed Insights測試結果卻是超過80分的”Good”,

比以前放在Pixnet還要快…..尤其目前這邊使用的主題Twenty Seventeen,

還是採用響應式設計(Responsive web design)、能適應不同裝置的佈景,

相較於以前還要跳到行動裝置專用頁面,怎麼看都是現在的網站可用性比較高啊….. 繼續閱讀

標籤: Blog, robots.txt, SEO, Wordpress, 站務相關

閱覽人數: 515

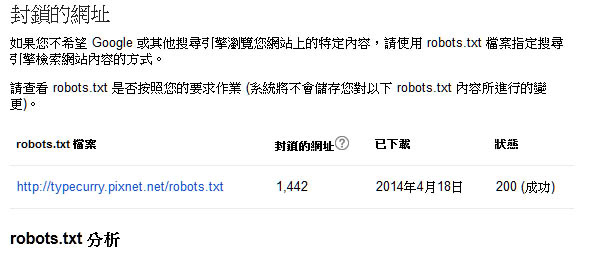

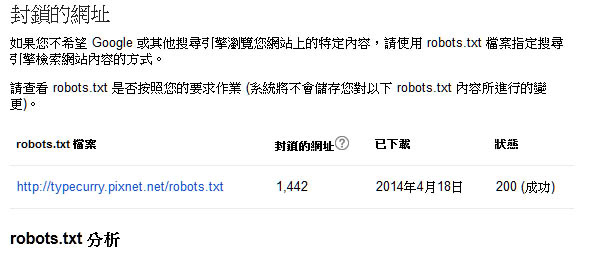

自Pixnet在3月29日停機維修後,本部落格的流量便瞬間劇降,

不但大部份在Google搜索中獨佔鰲頭的關鍵字連結一個個消失,

更甚者還有許多文章根本Google不到或僅能搜索到標題,

然後顯示一排”由於這個網站的 robots.txt,因此無法提供此結果的說明“;

雖然Norman沒有在這個部落格放廣告,所以流量多或少對經營的內在動機沒什麼影響,

但放公開部落格本來就是給人看,攪成這樣好像我每篇文章都鎖私密似的,

實在令人不太愉快…..自3月29日以來等了兩週雖有些許改善,

但直至今天,最近一次的檢索(4/18)仍顯示這邊有1400多筆網址被robot.txt所封鎖:

由於實在太誇張了(這邊總共也才幾篇文?),重新提交Sitemap、提交個別網址再索引等方式又都沒有效果,

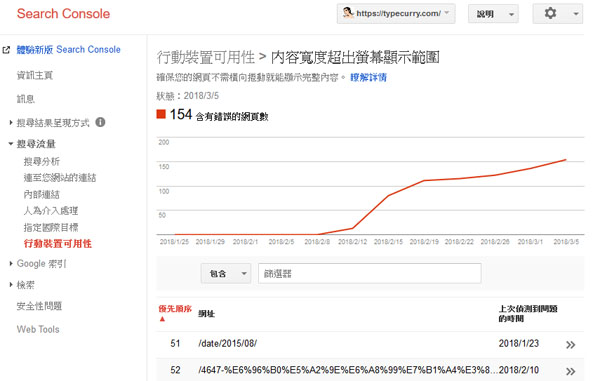

前幾日就向Pixnet的客服反映了相關事項;站方的回覆其實還滿快的,不過完全沒有解決問題…..

客服居然直接Google搜尋”http://typecurry.pixnet.net/blog”,

然後截一張有顯示”カレー補完計畫”的圖給我說沒事….喂喂,.這搜不到的話才大條吧!?

我想知道的明明是那他X的”由於這個網站的 robots.txt,因此無法提供此結果的說明“該怎麼解決啊…..

來個這麼誠懇又跳針的回答,搞得我都不曉得該如何繼續問下去了…..

之前看到有其他部落客號召打電話打爆Pixnet,想想我只是免費客戶還是別這麼玩…..

真搞不懂沒事去動robot.txt是玩那齣…..現下只能再等個幾天看有無改善了嗎 “orz 繼續閱讀

標籤: robots.txt, SEO, 站務相關